对于算法分发很多人会有所误解,这或许源自远观而缺乏了解,才会觉得算法猛如虎。而当你走近了算法分发,有了一定的了解之后,可能会有重新的认知:算法如虎,细嗅蔷薇。

算法分发知多少?

尽管算法分发中应用了各种高深的算法,但其基础原理却是朴素的:更好地了解待推荐的内容,更好地了解要推荐给的人,才能更高效的完成内容与人之间的对接。

从这个角度来看:断物识人,是一切推荐行为的起点。

对于断物识人,我们可以将它理解为打标签的过程。标签是对高维事物的降维理解,抽象出了事物更具有表意性、更为显著的特点。在不同的业务场景下,我们会选择不同的标签进行使用,来对内容和用户进行标注。

对于断物识人,我们可以将它理解为打标签的过程。标签是对高维事物的降维理解,抽象出了事物更具有表意性、更为显著的特点。在不同的业务场景下,我们会选择不同的标签进行使用,来对内容和用户进行标注。

在内容画像层面,以音乐为例,最典型的有两种标签产出的方式:

专家系统:潘多拉(Pandora)的音乐基因工程(Music Genome Project)。在这项工程中,歌曲体系被抽离出450个标签,细化到如主唱性别、电吉他失真程度、背景和声类型等等。每一首歌曲都会被经由工作人员耗时30分钟左右,有选择性标注一些标签,并以从0到5的分值代表这一标签的表征程度。

UGC产出:在豆瓣,给音乐打标签的活则从专家产出,转为了普通网友贡献。群体的力量为豆瓣积累了大量具有语义表意性的标签。当然,由于用户的多样性和编辑的开放性,用户标签系统需要经过特定的清洗和归一化才能投入使用。

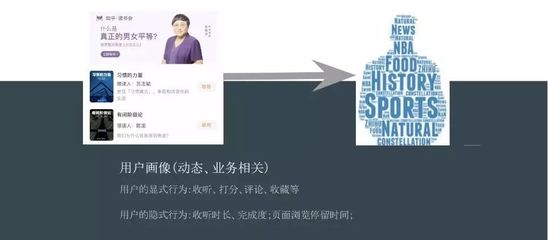

在用户画像层面,可以分为静态和动态两部分。

用户画像中静态的部分比较好理解,即你的设备信息、地理位置、注册信息等等,这些可以被理解为是业务无关的信息。具体到业务场景中,用户产生了更多的行为,就生成了业务相关的动态信息,即利用人的各种显式和隐式行为来对用户的偏好性进行的猜测。

以知乎读书会为例,你的显式行为是点击、收听、评分、评论等等;隐形行为则是收听完成度、是否有拖拽快进、页面停留时长等等。

通常,由于显式行为不够丰富,我们往往需要使用隐式行为来扩充我们对于用户的理解。完播率、是否快进、详情页停留时长等指标,都会被系统统计,用来判断你是否真的喜欢某个人的讲解、喜欢某本书的内容。

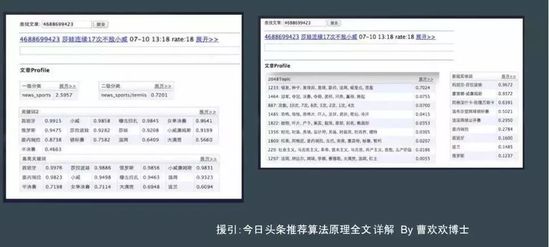

在内容画像的部分,可以看到一篇文章通过文本分析进行了一级和二级分类,并抽取出文章内的关键字、实体词,进一步的还会通过聚类的方式,将这篇文章与其相似的内容聚成一个簇类。之所以会有聚类,是因为专家系统的分类体系一定是对于变化不敏感的,响应不及时的,而聚类能够挖掘出更多内容的隐含信息。

在内容画像的部分,可以看到一篇文章通过文本分析进行了一级和二级分类,并抽取出文章内的关键字、实体词,进一步的还会通过聚类的方式,将这篇文章与其相似的内容聚成一个簇类。之所以会有聚类,是因为专家系统的分类体系一定是对于变化不敏感的,响应不及时的,而聚类能够挖掘出更多内容的隐含信息。

在用户画像的部分,“今日头条常用的用户标签包括用户感兴趣的类别和主题、关键词、来源、基于兴趣的用户聚类、各种垂直兴趣特征、以及性别、年龄、地点等信息。性别信息通过用户第三方社交账号登录得到。年龄信息通常由模型预测,通过机型、阅读时间分布等预估。常驻地点来自用户授权访问位置信息,在位置信息的基础上通过传统聚类的方法拿到常驻点。常驻点结合其他信息,可以推测用户的工作地点、出差地点、旅游地点。这些用户标签非常有助于推荐。”(摘录自今日头条推荐算法原理全文详解——曹欢欢博士)

内容画像和用户画像,是一个相互影响的循环系统。

内容画像决定人的画像,自然是最容易理解的。在音乐场景下,你收听、收藏、评分了很多爵士类的音乐,那么系统就会判定为你是一个喜欢爵士音乐的用户。在读书的场景下,你阅读、收听了哪些书籍,哪些书籍听完了、哪些书籍重复收听了很多遍,都会影响系统中,你的用户画像。

因此,“你的选择决定你的画像”可以说丝毫不为过。

而反过来,人的画像也会影响内容的画像。我们可以看作是基于用户的行为,对内容做出的后验投票。在一个大体量的视频上传体系里,我们基本放弃了依赖人工打标签的方式,而转而利用用户的播放行为来试图猜测内容属于哪一类。一个典型的Case:死神来了。看标题的文本信息,最大概率就是一部电影,但事实上观看这个视频的大面积是喜欢猎奇类视频的用户,深挖内容才会知道,这其实是一个车祸视频集锦。

协同过滤,应用群体智慧

如前所述,标签是我们对事物的抽象理解,那有没有一种方式能够让我们放弃标签呢?以人的行为来标记内容,这就是协同过滤的基础思想。

举一个生活中的场景,初次为人父母,“无证上岗”的新手爸妈们内心是激动而又惶恐的。打听,成了他们育儿的重要法宝之一。“你家宝宝用的是什么沐浴液啊、你们有没有上什么早教班啊…”亲子群中,无时无刻不在发生这样的讨论,这样的讨论也构成大家后续消费决策的主要因素之一。

这种基于人和人之间的相互推荐固然是弱社交关系分发的一种形态,但是促成大家有价值信息交换和购买转化的,其实是人和人之间的相似点:为人父母、拥有相似的价值观和消费观。

把用户的消费行为作为特征,以此进行用户相似性或物品相似性的计算,进行信息的匹配,这就是协同过滤(Collaborative Filtering)的基础思想。

协同推荐可以分为三个子类:基于物品(Item-based)的协同、基于用户(User-based)的协同和基于模型(Model-based)的协同。

基于用户的协同,即切合了上面的例子,其基础思路分为两步:找到那些与你在某一方面口味相似的人群(比如你们都是新手爸妈,倾向于同一种教育理念),将这一人群喜欢的新东西推荐给你。

基于物品的协同,其推荐的基础思路是:先确定你喜欢物品,再找到与之相似的物品推荐给你。只是物品与物品间的相似度不是从内容属性的角度衡量的,而是从用户反馈的角度来衡量的。使用大规模人群的喜好进行内容的推荐,这就是在实际工程环境里,各家公司应用的主流分发方式。

基于模型的协同,是应用用户的喜好信息来训练算法模型,实时预测用户可能的点击率。比如,在Netflix的系统中就将受限玻尔兹曼机(Restricted Boltzmann Machines,RBM)神经网络应用于协同过滤。将深度学习应用于基于模型的协同,也成为了业界广泛使用的方式。

以协同的方式,通过用户行为的聚类发现许多隐层的连接。

以读书会的场景为例,我们邀请不同的名家来领读书籍。从领读人的角度,更容易直观的将同一领读人的作品视作一个聚类,比如马家辉老师领读的《对照记》、《老人与海》两本书,通过人工预判的前置规则,我们很容易将这两本领读书音频推荐给同一类用户。

但是,通过协同的方式,我们会发现喜欢马家辉老师领读作品的用户,同时也会喜欢杨照老师领读的《刺杀骑士团长》一书。这种联系,是很难通过标签信息发现的,只有通过用户的行为选择,才会建立联系,提升内容和用户之间连接与匹配的效率。

从冷到热:内容和用户在分发中的生命周期

作为连接内容与人的推荐系统,无时无刻不在面对着增量的问题:增量的用户,增量的内容。

新的用户、新的内容对于推荐系统来说都是没有过往信息量积累的、是陌生的,需要累积一定的曝光量和互动量(阅读、分享等)来收集基础数据。这个从0到1积累基础数据的过程就是冷启动,其效果的好坏直接关系到用户端、作者端的满意度和留存率。

如果我们假设一篇新内容要经过100次阅读才能够得到相对可信的内容画像,新用户同样需要完成100次阅读之后才能够建立起可用的用户画像。那么一个最直观的问题就是:怎么样达成这100次有效的阅读?这就是冷启动面临的问题。下面我们从内容和用户两个维度来分别论述。

在推荐系统中,通过分析一篇内容的标题、关键字来确定要向哪个目标人群进行探索性展示,借由探索性展示完成了从0到1的用户反馈积累过程。在这个冷启动过程中,如果没能得到足够正面的用户反馈(点击行为和阅读体验),系统就会认为这篇内容是不受欢迎的,为了控制负面影响,就会逐步降低这篇内容的推荐量。

反之,如果内容在冷启动过程中顺利找到了自己的目标人群,收获了很高的点击率,就有可能被推荐系统快速放大,具有了成为爆款的可能。因此,冷启动决定一篇内容命运的说法,可以说丝毫不为过。

而对于用户冷启动,推荐服务的是一个大目标:用户的留存率。只有保证了用户留存的前提下,才会考量推荐的兴趣探索效果如何,是否在有限的展示里全面探索出了用户的偏好。对于慢热型的用户,我们并不急于获悉他的方方面面,而是以“留住用户”作为第一目的。

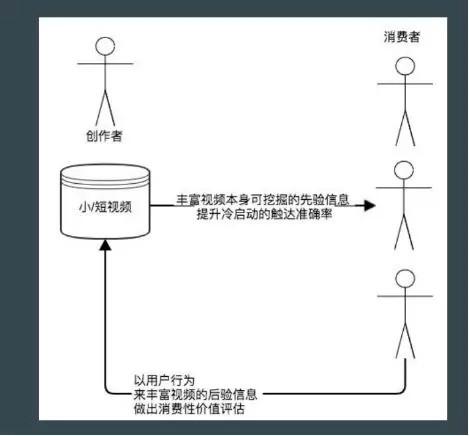

时下,最火热的莫过于快手、抖音类的PUGC视频应用了。那么,这些短视频内容的推荐方式是什么样的呢?

回归到丰富先验信息、依赖后验信息的角度来阐述整个通用的流程。

一个短视频应用里面,大体上会有三类人:半职业或职业的生产者、工具的使用者、短视频的消费者。从消费性的角度来看,大概率是第一类人生产,第三类人消费。先验信息就是尽可能挖掘出第一类人生产内容的固有特征,比如作者是谁、配的音乐是什么、是否有参与活动话题等等,对于足够的头部生产者还可能会以运营介入的方式人工标注,去完善先验信息。

客观上说,小视频的先验信息是远小于文本内容的。从信息量的角度来看,我们将其类比微博类的短文本内容或者全图片内容可能会更合适。先验信息的缺乏,就会更依赖协同算法支撑下,用户参与行为的后验信息的补充。

将一则小视频冷启动推荐给特定类别的用户来查看,从用户角度去统计不同特征、不同聚类用户的有效播放,从而以用户的行为去刻画小视频的特征。

比如,时下很热的海草舞,不同的生产者都会上传类似主题的视频,哪个更好?在业务场景里,真正值得依赖的一定是普通用户观看行为的投票,才能选择出更值得扩散内容,优化全局的效率。

三分天下?编辑、算法与社交

不夸张的说,算法分发将是未来信息分发行业的标准配置。

为什么这么说?因为算法是个筐,什么都能往里装。在内容展现和推荐的过程当中,可以参考下述公式:算法分发权重=编辑分发权重 + 社交分发权重 + 各种算法产出权重。

将任意一个权重设置为1,其他部分设置为0,算法分发系统就会变成一个标准的编辑分发系统或者是社交分发系统。也就是说,算法分发的基线就是编辑分发或社交分发。从这个角度来看,只要算法应用的不太差,基本上引入算法分发一定是正向。因为它在有限的货架里,围绕用户展示了无限的货品。

在业务层面,我们通常会复合型使用三种分发,在不同的环节应用不同的因素,才达到最好的效果。

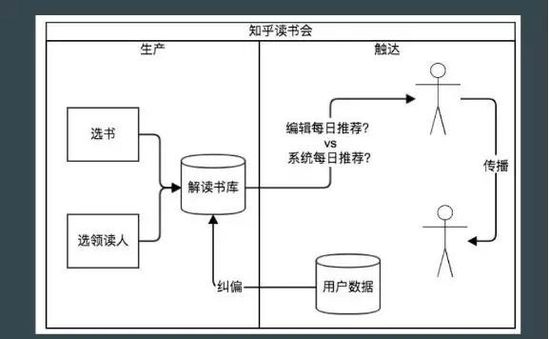

以知乎读书会为例,我们将其划分为:内容生产、用户触达和反馈改进三个部分。

在内容生产中,为了保证调性,一定是需要引入编辑专家去选人、选书的。选择的书是否有价值,选择的人是否是行业专家而非职业的拆书人,都是体现产品价值观判断的事情。

进入触达环节,人工干预的作用就会相对弱化。举一个例子,运营一定会有今日推荐的需求,推荐给用户今日读书会上新了什么大咖领读的书籍。比如,一本物理学的书籍,由一位物理学大咖进行解读。从编辑的角度,领读人是大咖,书是经典,编辑权重一定非常高。

这听上去似乎很合理,但当你进入用户的场景时,就发现有点差异:首先,用户不是每天都来的。如果他一周来一次,在他没来的这一周内同样有文学、互联网、艺术等专业人士的领读,你该给他的是今日推荐,还是本周推荐呢?进一步考虑到用户偏好问题。你是应该把物理学大咖的内容强加给他,还是推荐给他一个朋友们最近都好评的一本领读书(社交分发),又或者是他自己已经标注了“想读”的一本艺术类书籍的解读呢?

当我们收集到了足够多用户数据的时候,又可以反过来影响内容的二次迭代,编辑的作用又凸显了出来,结合数据的反馈来对内容进行调整:内容的播放完成率为什么低?是稿件问题,还是领读人语音的问题,是否需要重新录制等等。

算法的价值观

算法有没有价值观呢?算法没有价值观,算法背后的人却是有价值观的。

因为我们优化推荐系统,一定会有一个数值目标。这个数值目标的合理性决定了整个推荐系统的合理性。单独以点击为优化目标,一定会导致标题党泛滥;点击加时长目标能够一定程度抑制标题党的产生,但是也有可能导致用户多样性的丧失。在这里举两个内容消费的场景,我们可以通过这两个场景一窥各个内容分发产品的调性所在。

新用户冷启动:

大家可以以新用户的身份去尝试各种内容消费服务。比较之下,你就知道各家的价值观怎样的了。因为新用户是通过不同渠道获取的,你获取到的是怎样的用户,你就会推荐怎样的内容;进一步的,基于马斯洛需求模型,越底层的内容越有更广泛的受众。这就是为什么很多小视频应用,打开来之后,全都是白衣校花大长腿的原因了,人性尔。

推荐多样性:

多样性是另一个评估分发产品调性好坏的所在。丧失多样性,深挖用户的局部兴趣点,一定是短期收益最大化的。比如我喜欢看科比,那么你把科比的比赛视频推给我,可以让我刷到深夜两点;但是从一个产品的长线来看,我们需要更长久的留住用户,而不是短期让用户沉迷。在短期时长和长期留存中,就依赖于产品设计者的价值观判断了。

不同平台下的自媒体生态

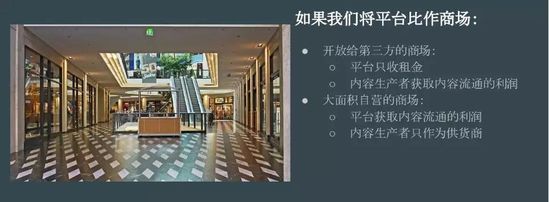

对于平台来说,创作者是什么?

如果把平台比作一个商场的话,不同的平台会有不同的选择,最典型的两种类型莫过于:自营V.S第三方运营。

一种情况下,整个商场全部是直营的店铺。在这样的平台下,每个货架都是商场自营,所有的创作者对于商场而言,都只是供货商。

另一种情况下,商场只提供位置,所有交得起入场费的店铺都可以入驻。在这样的平台下,每个货架都是创作者自己运营的。

直营商场的好处当然是体验可控、甚至于能够在某个特定垂类人群身上做到近乎可量化范围内的极致。由于其收取的是商品流通中的利润,所以在短期内可以攫取巨大的红利,并用这些利润去给商场自身打广告,做新客获取。

但这样做的坏处也很显然,就在于供货商的角度缺乏灵动性,只作为供货商的创作者,由于缺乏足够的利润激励,很难生长出全新的品牌。

开放给第三方运营的商场,其好处当然是供货商的灵活性和多样性,商场赚取的是房租而非商品流通过程的利润。一个常见的问题是,这种完全开放给第三方运营的商场是否会用户体验崩塌,比如会有各种在商场入口发小广告的,以各种图谋短线的方式来吸收商场的流量。这就是局部失控与全局可控的关系。

在国内,全部直营的商场比比皆是;近乎完全开放给第三方运营的大商场,则恐怕只有微信了吧。在所有平台都在告诉你什么是对的时候,只有微信很克制地告诉你什么是错的。

数据驱动自媒体迭代

站在自媒体的角度,又该如何面对平台?如何应用数据驱动的方式,更加目标导向的面对不同平台呢?

首先,自媒体面临的问题是平台选择。由于不同的平台有不同的分发规模和不同的发展阶段,所以,更应该选择适合自己品牌调性的平台,选择符合自己长线商业化变现角度的平台。要区分清楚,哪些平台是叫好不叫座、哪些平台是叫座不叫好。

首先,自媒体面临的问题是平台选择。由于不同的平台有不同的分发规模和不同的发展阶段,所以,更应该选择适合自己品牌调性的平台,选择符合自己长线商业化变现角度的平台。要区分清楚,哪些平台是叫好不叫座、哪些平台是叫座不叫好。

如果做电商导向的自媒体,那么基本上微博微信是必选项。考虑到目前各个平台相对封闭,不提倡向微博微信导流,那么其在其他平台可能更多的在于曝光量和品牌建设的贡献,而不会对电商的销售转化有太大的贡献。

但对于承接品牌广告的自媒体而言,其利润更多的和内容的传播量有关,在传播量导向的角度来看,就应该更多的选择和自己品牌调性相符的、哪怕是一些垂直类的内容分发网站。通过汇集全网各平台的流量,来实现自己对广告主的全网阅读量(播放量)的承诺。

因为每个平台的投入都需要牵涉到运营人力,所以如果一个平台的投入产出比不能够达到预期,就应该主动止损,避免进一步的资源投入。

在自媒体确定了自己选择的平台之后,就需要深究不同平台的分发特点,来进行针对性的运营从而提升自己在相应平台的曝光量。常见的三种平台:编辑分发、订阅分发和算法分发平台。

对于编辑分发平台,最快速的方法一定是维系好和平台的关系。因为在这样的平台上,其推荐位置都是人工分配的,更好的编辑关系能够保证自媒体有更好的流量曝光。在编辑分发的平台上,时不时的会有相应的官方活动、积极地配合官方导向,就能从流量倾斜政策中获取红利。

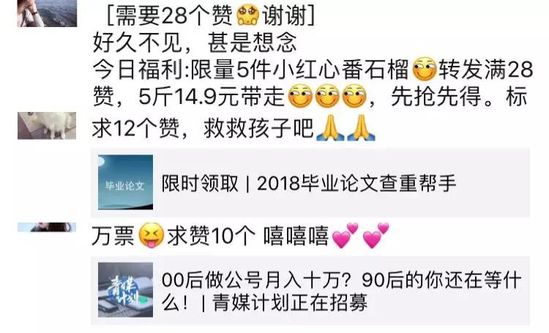

对于订阅分发平台,做粉丝,做垂直品类粉丝是不二法门。借由微信,其实大家能够看到一些常见的诱导分享的手段。由于微信是一个规定行业下限,而非设定上限的开放式环境。所以在这样的平台上进行运营,首先需要保证自己有足够高的敏感度,对于一些新的传播形态可以及时跟进,从而最大化的获取时间差的红利。比如,最近的微信小游戏,在前两周铺天盖地的通过微信群分享获得拉新机会;而最近几日,这条通路就完全被官方封禁了。

对于算法分发平台,尽管平台关系维护和粉丝数积累都需要,但是最需要投入的还是对于内容的包装。因为你的内容不仅仅要抓住人的眼球,同时也要能够对机器算法的胃口,通过研究过往一段时间的平台热门关键词,能够给内容的标题封面包装提供一些借鉴。

在我看来,运营的非常好的一个自媒体品牌非二更莫属,细细观察,其在不同的平台上都有不同的运营策略。比如,在头条上的分发,二更就全面的在使用双标题、双封面的方式进行自己的内容包装。一些视频内容能够在非常短的时间内就获得了上百万的曝光量。

不同平台上的不同运营方式,本质上还是一个数据驱动,目标导向的过程,以下进行更细粒度的拆解。

他山之石可以攻玉,首先和大家介绍的是在国外,将数据分析指导内容生产做的非常极致的BuzzFeed。

员工总数逾千人,拥有全球新闻团队、自家视频制作工作室、尖端数据运算中心和内部创意广告机构,每月全网超过50亿次阅读——这就是BuzzFeed,怎么看都是一个庞大的媒体集团。

然而,当我们深入了解BuzzFeed的工作流程后就会发现,与其说它是一家媒体公司,不如说它是一家科技公司。“数据驱动内容创作”,这是BuzzFeed给自己贴上的标签。

在这家公司的内容创作和分发过程中,反馈闭环(Feedback Loop)是出现频次最高的术语:通过将市场环境和读者反馈数据尽可能的量化和结构化,及时反馈给运营人员、内容编辑,从而构成了辅助创作的一个闭环。

由于很早就树立了“将内容分发到用户常驻的平台,而非吸引用户到自己的平台看内容”的思路,YouTube、Facebook,Twitter、Vine等一众平台都成为了BuzzFeed的战场。为了更好的理解用户反馈,BuzzFeed追踪收集并汇总了各个平台上的阅读传播和互动数据。比起阅读量、分享量这些结果指标,其更关心内容分发和传播的过程。

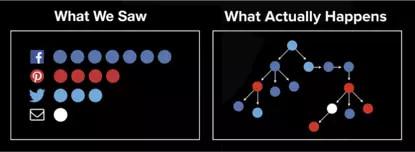

以下图为例:如果只看终态数据,那么报表展示给你的无非是一篇内容从不同的平台渠道上获取了多少流量而已(下图左)。但是深究下来,这些流量是如何来的呢?是通过Facebook或Twitter上的分享,还是通过邮件的传播?哪些节点带来了更大的辐射量和扩散量?只有深入分析传播路径,才能给出这个问题的答案(下图右)。

不止于结果,BuzzFeed开始探究一篇内容的传播轨迹,他们开了一套名为Pound(Process for Optimizing and Understanding Network Diffusion)的系统,通过给同一页面的不同分享追加不同参数的方式,来追溯内容在网络上的传播过程。

通过这套系统,人们意识到:传播并不是一棵简单的传播树,而是一片密集的传播森林。每一次分享都构成了一棵新树,如果一个人的社交好友很多,那么这个节点的一度关系触达就会很广。如果内容的质量一般没有引发进一步的传播,那么就会止步为一棵低矮的树;如果内容引发了大量的传播,就会变为一个繁茂的大树。

由于社交传播对于内容的影响力贡献巨大,BuzzFeed在衡量内容价值时,会更看重社交分享所带来的阅读量,并以名为“病毒传播提升系数(Viral Lift)”的指标来衡量这一过程。

对于粉丝已经超过百万、内容阅读篇篇10W+的自媒体大号来说,这一衡量指标的制定不难理解:如果一篇内容的阅读构成主要来自于自己的粉丝,那么就意味着粉丝们更有可能是基于惯性打开的,但是由于内容并没有触及到它们的兴奋点、没能引发认同,从而失去了进一步扩散传播的可能,也失去了触达更多潜在粉丝的机会。

对于BuzzFeed而言,在相近的总阅读量下,一篇“病毒传播提升系数”更高的内容,因为收获了更多的社交传播而变得更有价值。有了技术追溯的支持,内容团队才能够总结出不同平台之上的内容偏好和病毒传播模式。

人们往往会夸大BuzzFeed的内容三把斧“清单体、短视频和小测验”,却忽视了在这些内容背后更深层次的数据支持。

具体到我们日常的内容阅读分析和粉丝分析过程当中,有哪些可以供分析注意的数据?

对内容分析来看,可以分为一次打开和打开后的体验。

一次打开是指不依赖于社交传播和搜索传播所带来的阅读量。对于微博微信等粉丝分发平台,是指粉丝带来的阅读量;对于头条、快报等推荐分发平台,是指经由推荐带来的应用内阅读量。

影响内容一次打开率最直接的因素有两个:活跃粉丝量和内容包装。

无论是粉丝分发平台还是推荐分发平台,活跃粉丝量都会影响内容展示的基本盘,只是传导系数不太一样罢了;对于粉丝分发的平台,你有多少活跃粉丝就意味着有相应比例的基础展示量;对于非粉丝分发的平台,你的活跃粉丝量会被视作你在平台上的贡献程度和受众情况从而影响分发权重。同样的一篇内容,10万活跃粉丝的账号发布一定比1万活跃粉丝的账号发布会获得更大的基础展示量。

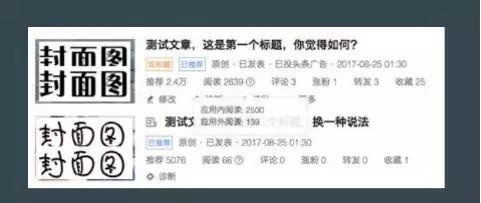

内容包装影响的是从展示量到阅读量的转化过程,更好的标题和封面图就像是精致的产品包装一样,有助于更好的促成转化。比如在头条号平台上,就支持了一个非常酷的双标题双封面功能,能够给创作者对内容不同包装的机会。

对于标题,我习惯于引用咪蒙的观点:“不能在一秒钟看明白的标题,不适合传播,不是读者理解不了,而是他只能给咱们一秒钟。”

在咪蒙的工作方式中,她会把当天写好的内容发出来,交于自媒体小组的员工开始取标题。15-20分钟内,每人至少取5个标题。这样,每一篇内容背后,都有近100个标题!咪蒙随后会从中挑出5-6个标题,放到3个由用户顾问群里投票(每个顾问群都有人负责统计票数)。 咪蒙会参考最终的投票结果,决定用哪一个标题。这种方式,其实就构建了一个最朴素的AB系统来验证标题对于内容一次打开率的影响。

为了便于比较,我们通常计算一次打开率而非打开量。对于粉丝分发平台,一次打开率=阅读量/粉丝量;对于推荐分发平台,一次打开率=应用内阅读量/推荐量。一次打开率对于不同分发模式的平台有不同的意义:

在粉丝分发的平台上,一次打开率能比阅读量更好地衡量自媒体账号的价值。为了保证更高的一次打开率,需要更科学地获取精准粉丝、重视粉丝群体的互动维护,使得自身始终能够保持较高的粉丝触达率。

对于推荐分发平台,一次打开率考量了自媒体对平台分发特点的认知和对内容包装功力。一次打开率(推荐点击率)高就意味着具有成为爆款的可能。甚至会收获比粉丝分发平台更大的阅读量。

阅读体验

如果说一次打开代表了上门推销人员成功敲开了用户的房门,那么阅读体验衡量的就是用户是否会为这次推销最终选择买单。

用户是带着对作者品牌和对标题封面的认知预期打开内容的,只有实际消费体验与预判一致、甚至超出预判,才算得上是好的阅读体验。我们之所以抵触标题党,并非因为它骇人听闻,而是因为用户抱着骇人听闻的预期,点击进入详情页之后才发现内容平淡无奇。

想要衡量消费体验,内容的消费比例是一个重要的指标。对于图文来说这个指标是平均阅读进度和阅读速度;对于视频来说是播放进度和播放时长(因为用户会有快进的行为,所以100%的播放进度并不意味着100%的播放时长)。平均消费比例越高,代表用户的认可度越高、消费体验越好。

除了内容消费比例指标以外,内容是否引发了读者互动也是一个常见的考察角度,如评论、点赞、收藏、转发等,这些指标的横向对比通常用于组织内部考核不同编辑的创作能力。其中,个人建议需要额外关注的是评论和转发两个指标。

评论扩展了内容的深度,更多的用户评论给正文提供了不同的视角分析和信息补充,可以有效的引发围观用户的阅读兴趣,提升用户在内容页的整体停留时长。促进评论的提升算是有一些技巧性的部分:选题有冲突性或者有代入感,在正文中留有悬念,主动引起讨论、投票,在评论区中带节奏等等都是行之有效的方式。

转发扩展了内容的广度,更多的转发能够带来更多面向潜在受众的曝光,这一点对于以粉丝分发为主要模式的系统尤甚。对于转发指标,我们可以套用BuzzFeed的病毒传播系数的计算方式:Viral Lift=1+ 传播阅读量 / 一次阅读量。

粉丝增长分析

对于自媒体而言,虚高的粉丝数除了忽悠投资人和广告主以外,对自身成长是毫无意义的。想要可持续发展,只有精准的粉丝才有价值。那什么是精准的粉丝?我想,应该是指能够给自媒体带来变现价值的粉丝。

粉丝增长分析,就是围绕有变现价值粉丝算的一笔账:如果一个粉丝能给自媒体带来5块的净利润,那么花低于5元的成本来购买这个粉丝就是划算的。

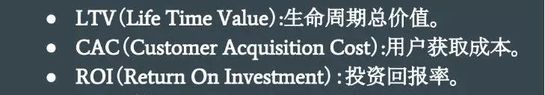

首先,引入三个概念——LTV、CAC和ROI。

LTV(Life Time Value):生命周期总价值。一个粉丝从关注你的那一天开始到取关或者脱离平台为止,能够带来的收益。通常按渠道来计算,如果某个渠道或某个平台的用户不精准、付费意愿差,那么这个渠道的用户LTV就相对较低。

CAC(Customer Acquisition Cost):用户获取成本。同样跟渠道有关,自媒体需要持续的发现低价、优质的渠道,抢占红利期。比如2015年初,微信广点通渠道的公众号涨粉,单个用户获取成本只有1-2块钱。

ROI(Return On Investment):投资回报率。计算公式为(收入-成本)/成本。应用于粉丝增长场景就是(LTV-CAC)/CAC,衡量的是:你从一个粉丝身上挣到的钱,是否能够覆盖获取这个粉丝的成本。

通常应该做ROI>1的事情,这样才能够保证业务的可持续发展。后续也都围绕这个角度展开。

首先,现身说法,举一个亲身犯下的“人傻钱多”的蠢事。15年初,微信朋友圈集赞的路数还很火热,我们也不能免俗,搞了三场集赞有礼的活动。三场集赞有礼的活动,表面上看起来一面光鲜,各种指标在活动日都有显著的提升。但是兴奋过去之后的分析,却让人笑不出来了。三次活动中,发起活动的老用户重叠度越来越高,带来的新用户越来越少,同时,新用户的次日留存情况也越来越差。

于是,我们开始反思用户为什么要参加集赞有礼的互动?唯利尔。

老用户发起活动,他所带来的新用户无非是看一眼品牌广告,帮朋友支持一下。如果实物奖品价值还不错,那么这个新用户也会发起,但目的在于奖品而非公众号。此外,设计过高的门槛使得有的用户不乐意参与,有的用户则自建了群开始互相点赞,达不到拉新的作用。

想要提升用户增长的ROI,就必须降低新用户中非精准用户的比例,从而拉升渠道用户的LTV,降低用户获取成本CAC。

由此入手,我们优化了转发集赞拉新的方式,新一期集赞活动的礼品是凯叔西游记第二部的部分章节收听权,每个用户只需要拉5个用户就能获得。因为是虚拟产品,CAC得到了显著降低。而儿童故事音频跟微信账号捆绑只能自用,用户如果不是真有需求就绝不会参与活动,从而提升了新增用户的精准程度。在后续的此类活动中,我们都有意识的对礼品的形态进行了控制:实物礼品用于鼓励已有的活跃老粉丝,虚拟礼品用于激活和拉新。

运营微博、微信这样的平台,我们很容易沉迷于追求短期粉丝数字的飙涨而举办各种活动。某些活动拉新从CAC的角度看或许是划算的,但深究其所带来的真实活跃粉丝,就往往会发现ROI远远小于1,充其量只能算是一次展示广告曝光,做了一笔又一笔的蚀本生意。

想要算清楚用户的ROI,有赖于用户身份的识别和渠道的追溯。在这一点上,微博和微信的基础建设比较完善。以微信为例,基于平台提供的二维码,我们可以追溯不同用户的来源并标识,就像是安卓应用下载对于不同的应用市场打不同的渠道包一样。进而,通过平台提供的外链功能、私信功能,来识别用户的活跃情况。

对于付费增粉渠道,每隔一段时间暂停一些,比较渠道暂停前后自己粉丝量的增长情况和粉丝阅读占比、线上活动粉丝参与量情况,建立起对付费渠道更清醒的了解。

通过数据分析的方式,能够让我们更加清醒的审视内容创作的消费性好坏,粉丝积累的性价比高低,从而以更经济的方式提升自己的增长速度。